PR

transformers

-

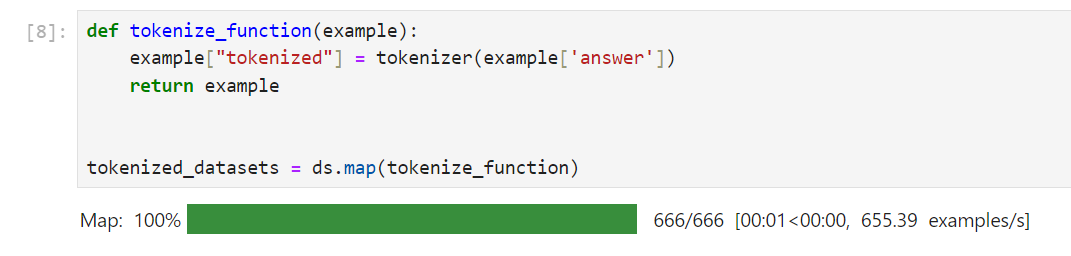

PythonでDatasetsのmapメソッドを使ったデータ整形の方法

-

数学に特化した言語モデル!NuminaMath-7B-TIRグラフの表示や数学の問題を解く

-

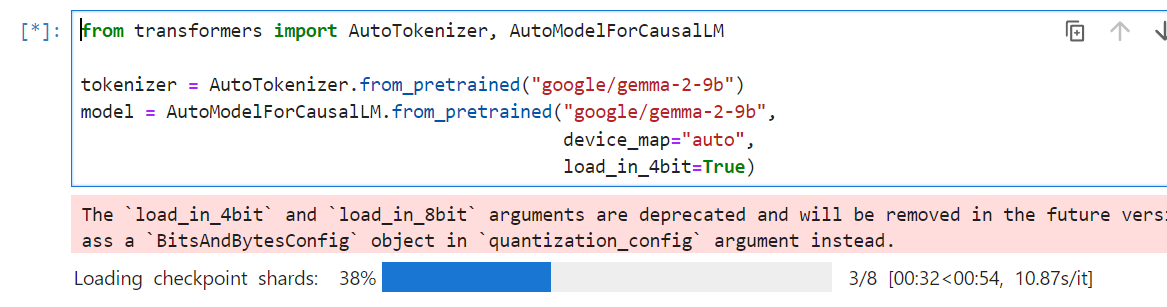

ValueError: The checkpoint you are trying to load has model type `gemma2` but Transformers does not recognize this architecture.の解決方法!gemma2の読み込み

-

meta-llama/Meta-Llama-3-8Bの使い方!導入から活用までの徹底解説

-

bert-base-japanese-v2の使い方!MASKされた日本語を推測する

-

deepsetのbert-large-uncased-whole-word-masking-squad2の使い方!Question Answering

-

bert-base-casedの使い方!Case Sensitiveを確認する!

-

bert-large-uncased を使ってみよう!MLMを試す!

-

bert-base-uncasedの使い方!マスクされた単語を推測する!

-

【Transformers】SwallowをHugging Faceで使う方法