機械学習・ディープラーニング

-

huggingfaceの.cacheの肥大化!シンボリックリンクで解決!

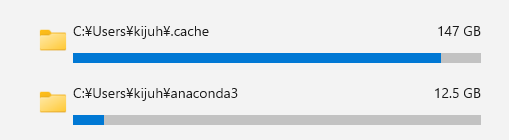

Hugging Faceキャッシュフォルダのシンボリックリンク設定方法 Hugging Faceのモデルやデータセットを利用する際、キャッシュフォルダが大きくなることがあります。特にSSDの容量が限ら …

-

Flaskで始める固有表現抽出!SpaCyとGiNZAを使った固有表現抽出(ner)の作り方!

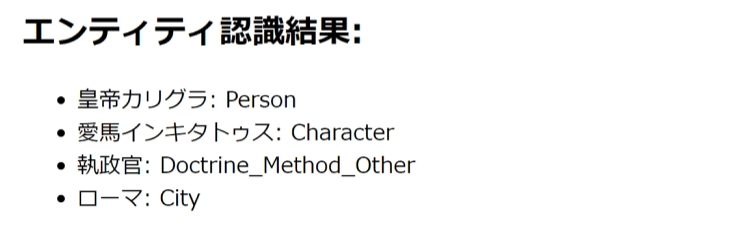

固有表現抽出とは 固有表現抽出(Named Entity Recognition, NER)は、自然言語処理(NLP)の一分野で、テキストから特定の種類の固有名詞を識別し、分類する技術です。具体的には …

-

数値微分の基本!前進差分法、後退差分法、および中心差分法について

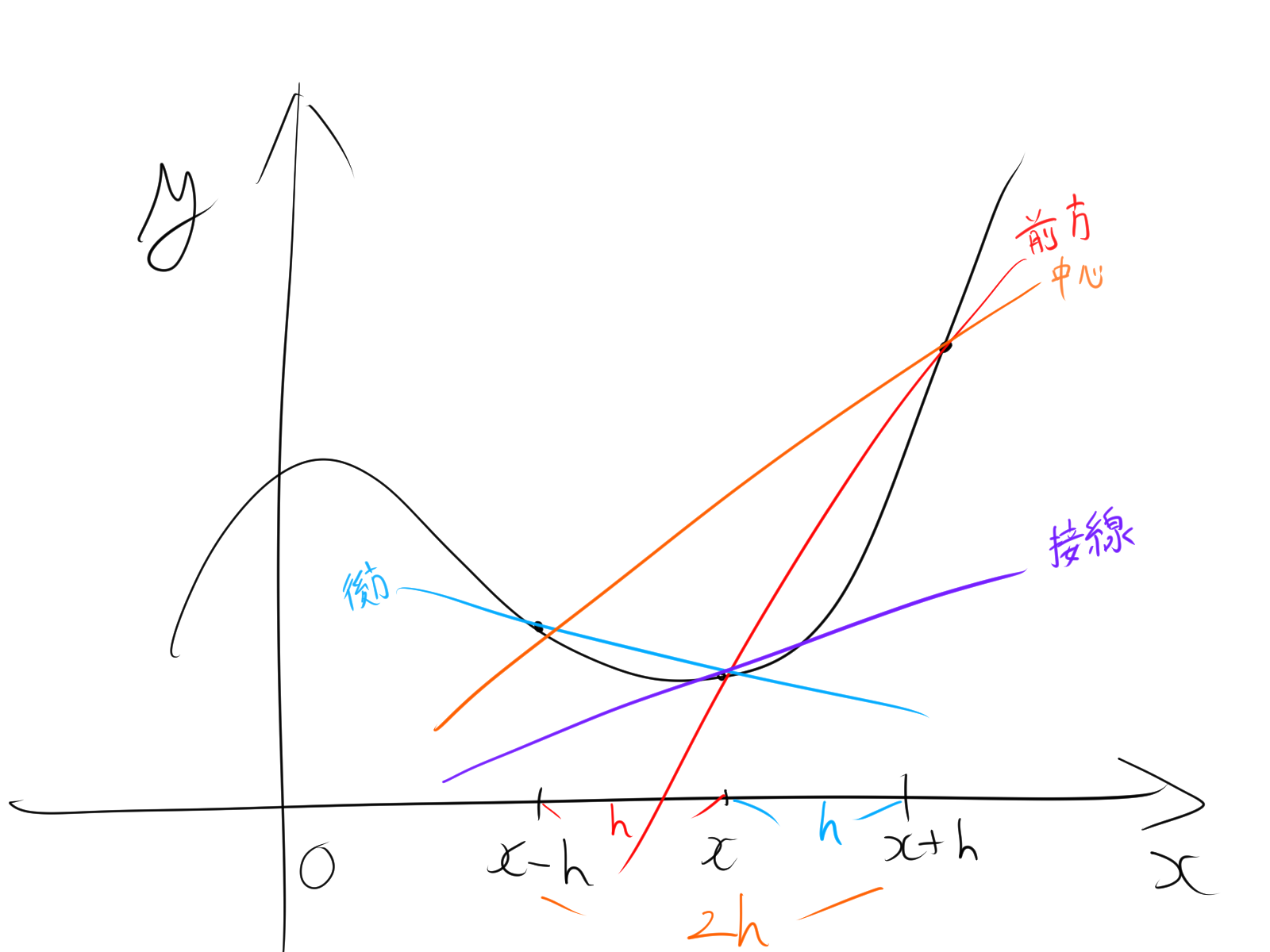

数値微分の基本的な方法 数値微分は、関数の導関数(微分)を数値的に求める手法です。これは、関数が解析的に微分できない場合や、関数の式が知られていない場合に特に有用です。数値微分の基本的な考え方は、関数 …

-

勾配(gradient)について!意味とディープラーニングへの応用について

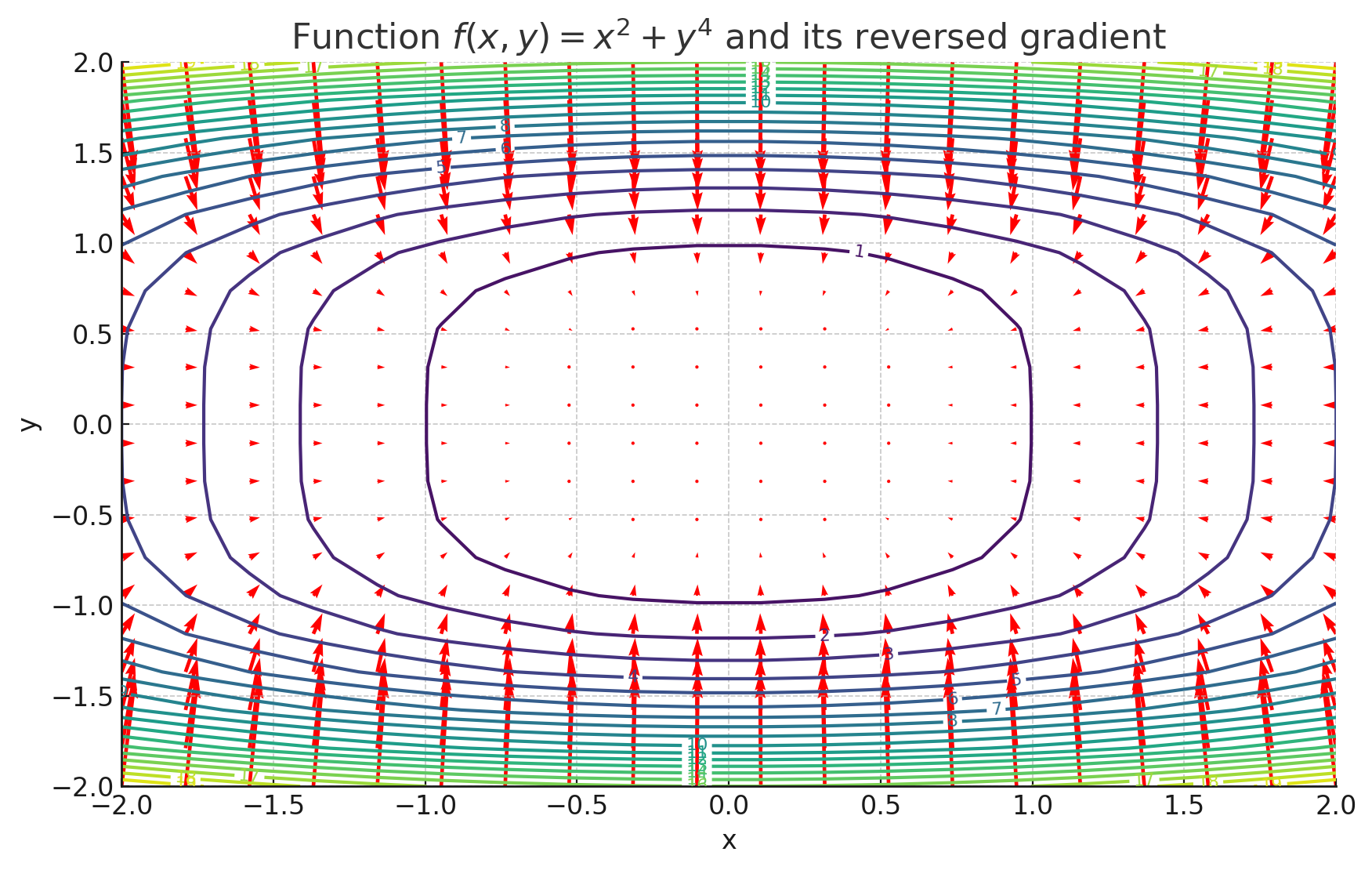

勾配とは 勾配の特徴 勾配の計算の具体例 2変数関数 \( f(x,y) = x^2 + y \) の勾配は、関数の各変数に関する偏微分を計算することで求められます。勾配ベクトルは次のように定義されま …

-

deepsetのbert-large-uncased-whole-word-masking-squad2の使い方!Question Answering

BERTとは BERT(Bidirectional Encoder Representations from Transformers)はencoderのみの言語モデルです。bert-large-un …

-

bert-base-casedの使い方!Case Sensitiveを確認する!

BERTとは BERT(Bidirectional Encoder Representations from Transformers)はencoderのみのモデルです。bert-base-cased …

-

bert-large-uncased を使ってみよう!MLMを試す!

BERTとは BERT(Bidirectional Encoder Representations from Transformers)はencoderのみの言語モデルです。bert-large-un …

-

bert-base-uncasedの使い方!マスクされた単語を推測する!

BERTとは BERT(Bidirectional Encoder Representations from Transformers)はencoderのみのモデルです。bert-base-uncas …